Anleitung · 7 min read

Automatisch vs. Manuell kodierte Emotionen vergleichen

Erfahren Sie, wie Sie INTERACT nutzen können, um automatisch erkannte Emotionen mit manuell kodierten Beobachtungen für eine umfassendere Verhaltensanalyse zu vergleichen.

Erfahren Sie, wie Sie automatisch beobachtete Emotionen mit manuell gesammelten Beobachtungen in INTERACT vergleichen können.

Herausforderung & Zielzusammenfassung

Ziel dieser Studie ist es, automatisch erkannte Emotionen mit manuell kodierten Emotionen zu vergleichen.

Wir möchten die Perioden expliziter Emotionen aus automatisch gemessenen Daten extrahieren, um diese Fragmente im Video anzusehen. Zusätzlich möchten wir den Strom der gemessenen Emotionswerte gleichzeitig anzeigen, während das Video abgespielt wird.

Am wichtigsten ist jedoch die Fähigkeit, Kontingenten und Co-occurrences zwischen visuellen Beobachtungen, diskutierten Themen und den emotionalen Reaktionen der beiden Teilnehmer zu finden.

Die größte Herausforderung, der wir uns hier stellen, ist:

- Nutzbare Fragmente für spezifisch automatisch gemessene Emotionen zu extrahieren. Das bedeutet, dass wir frame-basierte Messungen in Verhaltens-Ereignis umwandeln müssen, wann immer ein bestimmter Wert überschritten wird.

- Vollständige Transkriptionen natürlich gesprochener Wörter während der Beobachtung zu integrieren.

Das Ziel ist:

- Automatisch gemessene positive Emotionen mit manuell erfassten Sequenzen zu vergleichen, während derer der Beobachter den Ausdruck als positiv interpretierte.

- Co-occurrences zwischen Sprecher und gemessenen Emotionen zu finden.

- Die Verwendung von Wörtern pro Teilnehmer zu analysieren.

So können Sie vorgehen:

Studiendesign

Als Quelle verwenden wir eine aufgezeichnete Fernsehdebatte zwischen den Politikern Frau Merkel (CDU) und Herrn Steinbrück (SPD). Das Video wird von einem System verarbeitet, das Emotionen automatisch erkennt. Es wird auch manuell mit der Mangold INTERACT Software kodiert. Um die gemessenen Werte zu synchronisieren und zu integrieren, wird zusätzlich das Add-on-Tool benötigt.

Datenerhebung

Zur Erfassung automatisch erkannter Emotionen wurde das Video vom Microsoft Emotion API Service1 frame für frame analysiert, was zu einer langen Liste mit gemessenen Werten führte.

Zusätzlich wird Mangold INTERACT verwendet, um alle Beobachtungen zu bewerten, angefangen bei der Kameraansicht und dem aktuellen Sprecher bis hin zu Gesten und beobachteten Ausdrücken.

Vorbereitung der Daten-Erfassung

Für die Datenerhebung mit INTERACT haben wir mehrere Code-Definitionsdateien vorbereitet, die in verschiedenen Durchläufen des Videos verwendet werden können. Pro Durchlauf kann ein anderer Satz von Codes verwendet werden, um die Anzahl der auszuwählenden Codes zu begrenzen. Um den Kodierprozess pro Durchlauf zu optimieren, ist es sogar möglich, verschiedene Kodier-Modi innerhalb desselben Dokuments anzuwenden.

Für unser Experiment benötigen wir mindestens einen Satz von ‘Emotions’- oder ‘Affekt’-Codes, da wir positive und negative Affekte pro Teilnehmer manuell beobachten und erfassen möchten, sobald sie auftreten. Berücksichtigen Sie also eine Klasse ‘Emotion_M’ und ‘Emotion_S’, beide mit den Codes ‘Positiv’, ‘Neutral’ und ‘Negativ’.

Wie erwähnt, wurden auch weitere Informationen gesammelt, aber diese sind für diesen Vergleich nicht wichtig, daher konzentrieren wir uns auf die Emotionsdaten.

Beobachtungen sammeln

Wenn Sie mehrere Durchläufe benötigen, um Ihre Daten zu sammeln, beginnen Sie mit Informationen, die leicht zu beobachten sind, wie z.B. wer sich im Kamerabild befindet, indem Sie beispielsweise den Fokus und die aktuell sichtbaren Personen angeben. Das Erkennen komplizierterer Verhaltensweisen ist einfacher, wenn Sie das Video zuvor angesehen haben.

Sobald Sie die ‘Emotionen’ erfassen, können Sie die zuvor kodierten ‘im Kamerabild’-Ereignisse für den jeweiligen Teilnehmer verwenden, um die interessanten Teile im Video schnell zu finden (Sie können die Teile überspringen, in denen Ihre interessierte Person nicht sichtbar ist).

Details dazu, wie genau Ihre Codes erfasst werden, sind nicht Teil dieses Beispiels, daher überspringen wir dies und gehen davon aus, dass die Daten bereits gesammelt wurden.

Analyse

Bevor wir die automatisch generierten Daten mit den manuell kodierten Daten vergleichen und diese Daten synchron zum Video ansehen können, müssen wir die gemessenen Daten in Mangold DataView importieren.

Import von Emotionsdaten

Der Import jeder Art von gemessenen Daten erfordert die Kenntnis des genauen Synchronisationspunkts zwischen Video und Daten. In diesem Fall ist die Synchronisation einfach, da die Emotionswerte ganz am Anfang des Videos beginnen.

Der DataView-Import-Assistent führt Sie durch den Importprozess, aber auch das ist nicht Teil dieses Beispiels.

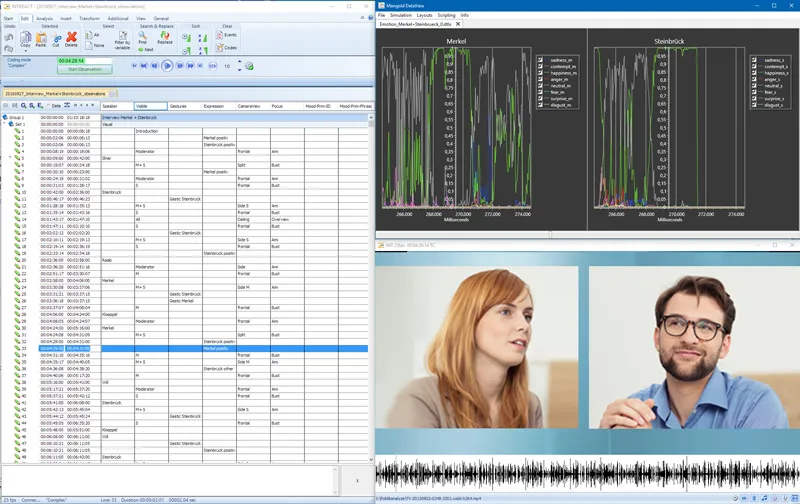

Nachdem die Emotionsdaten erfolgreich importiert und ein benutzerdefiniertes Layout in DataView erstellt wurde, das ein separates Diagramm pro Person anzeigt (um die gemessenen Emotionen für beide Teilnehmer zu bündeln), sieht unser Setup so aus:

Mangold DataView und Mangold INTERACT verbinden sich automatisch, basierend auf den Zeitinformationen des Videos und denen der gemessenen Werte. Das Abspielen des Videos lässt die Emotionsdaten-Diagramme synchron laufen. Das Wiedergeben von manuell bewerteten Ereignisse zeigt automatisch die entsprechenden Emotionswerte in den Diagrammen an.

Um die Ergebnisse der automatischen Emotionserkennungssoftware detailliert mit den manuell kodierten Daten und dem Video zu vergleichen, müssen wir die gemessenen Werte in INTERACT-Ereignisse umwandeln.

Die Software zur automatischen Emotionserkennung liefert Werte zwischen 0 und 1 pro Videobild. Die resultierenden Werte werden in verschiedenen ‘Emotionskanälen’ gespeichert. Dieses System erkennt immer eine Kombination von Merkmalen für mehrere Emotionen gleichzeitig, daher müssen wir diese Werte interpretieren, um emotionale Ereignisse für positiven und negativen Affekt zu extrahieren.

Emotionale Ereignisse extrahieren

Basierend auf den gemessenen Werten pro Emotionskanal erstellen wir INTERACT-Ereignisse aus DataView heraus.

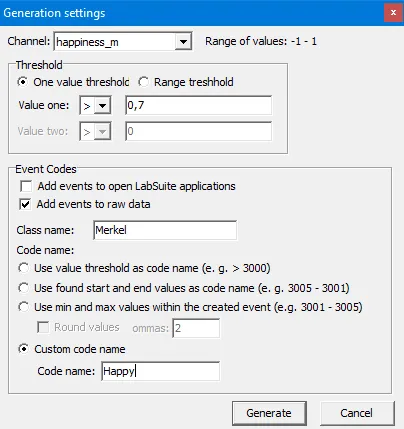

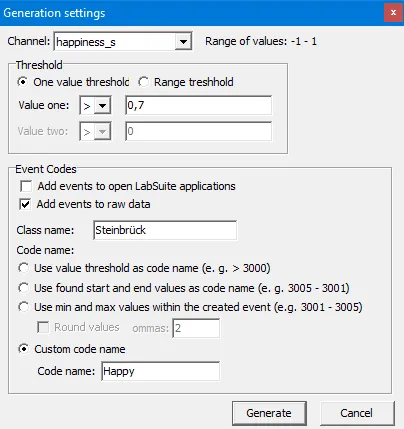

Eine Skriptroutine kann Ereignisse basierend auf Kanalldaten generieren. Sie können einen Kanal und einen Schwellenwert auswählen, wonach alle nachfolgenden Zeilen, die den angegebenen Schwellenwert erfüllen, zu einem einzigen INTERACT-Ereignis zusammengefasst werden.

Auf diese Weise können wir Ereignisse mit dem Code ‘Glücklich’ generieren, die alle Perioden abdecken, in denen der Kanal ‘Glücklich’ für Frau Merkel über 0,7 steigt, das Gleiche gilt natürlich auch für Herrn Steinbrück.

Für unsere Studie sind auch die Sequenzen von Interesse, in denen der ‘Wut’-Kanal der Teilnehmer über 0,7 steigt, um negative Affekt-Ereignisse zu generieren.

In DataView können wir die Klassenspalte und den Verhaltens-Code für jede schwellenwertbasierte Suche separat festlegen. Das Generieren aller Sequenzen für positiven und negativen Affekt für beide Teilnehmer erfordert nur vier separate Durchläufe derselben Routine mit angepassten Einstellungen.

Alles in allem dauert dies maximal 5 Minuten!

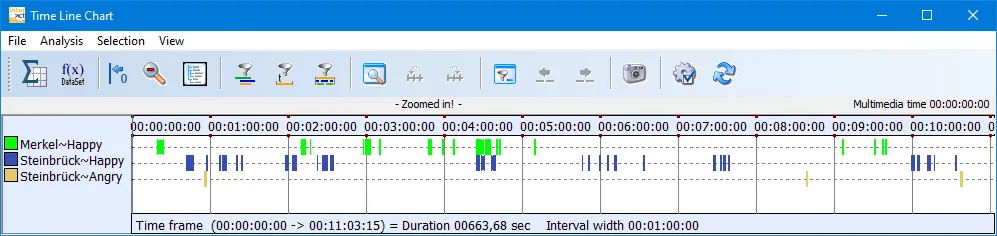

Nun können wir die Statistiken unserer manuell kodierten ‘positiven’ Ausdrücke und der automatisch generierten Ereignisse für ‘Glücklich’ in den vollständigen Statistiken vergleichen.

Wir können die Ausdrücke auch visuell überprüfen, indem wir die Ereignisse wiedergeben, die von DataView basierend auf den gemessenen Werten generiert oder manuell kodiert wurden.

Die Statistik zeigt uns, dass Frau Merkel möglicherweise recht oft als ‘glücklich’ registriert wird (Häufigkeit=51), es aber normalerweise weniger als eine halbe Sekunde dauert (mittlere Dauer):

Die Statistik zeigt uns auch, dass Steinbrück, obwohl er sowohl in Bezug auf Häufigkeit als auch Dauer öfter ‘glücklich’ zu sein scheint als Merkel, Merkel diejenige ist, die am längsten ‘gelacht’ hat (max. Dauer von ‘glücklich’).

Der Vergleich der von DataView generierten Codes mit den manuell erfassten Beobachtungen zeigt einen großen Unterschied zwischen dem, was nach den beiden Methoden als positiver Affekt angesehen wird, allein durch Betrachtung der einfachen Statistiken. Das Anpassen des Schwellenwerts kann die Ergebnisse für eine bessere Übereinstimmung optimieren. Dafür ist keine Co-occurrence Routine erforderlich.

Co-occurrences

Der Vergleich der gemessenen Emotionen für Merkel oder Steinbrück pro Sprecherwechsel kann mit dem State-Space-Grid durchgeführt werden. Im Bild sehen Sie die gemessenen Emotionen von Steinbrück im Vergleich zum aktuellen Sprecher:

Auch ohne die ausgeklügelte Extraktion automatisch erkannter Emotionen liefert uns die Bewertung der Sprecherzeit interessante Informationen. Zum Beispiel: Der Filter “Trim on code” liefert uns Details darüber, wer sonst noch während Steinbrücks oder Merkels Sprechzeit sprach:

Da die INTERACT-Statistiken nur das widerspiegeln, was derzeit im Zeitdiagramm sichtbar ist, passt die Begrenzung der angezeigten Ereignisse die Statistiken automatisch an.

Wortverwendung

Wir haben eine vollständige Transkription der Sprecherwechsel erstellt und die Transkription pro Sprecher-Ereignis in den Transkriptionsbereich in INTERACT eingegeben. Um die Wortwahl pro Sprecher zu analysieren, müssen wir alle Sprecher-Ereignisse neu organisieren und diese in einem separaten DatenSet pro Sprecher gruppieren. Dies kann mit wenigen Mausklicks unter Verwendung eines der leistungsstarken Umstrukturierungsbefehle erfolgen. Sobald alle Sprecherwechsel pro Sprecher gruppiert sind, zeigen Ihnen die Statistiken der Textanalyse auf einen Blick, welche die beliebtesten Wörter unserer Sprecher sind.

INTERACT: Eine Software für Ihren gesamten Forschungs-Workflow

Von der Datenerfassung bis zur Analyse – einschließlich GSEQ-Integration – INTERACT deckt alles ab.